Campionamento

I secondi vengono definiti prendendo come campione di tempo il periodo di oscillazione delle onde luminose emesse da un atomo di cesio 133 in una particolare transizione atomica. YouMath

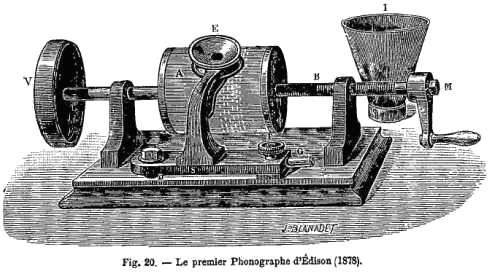

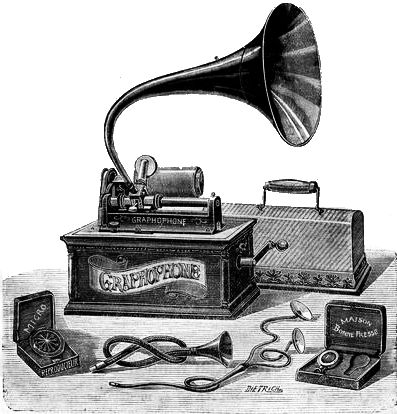

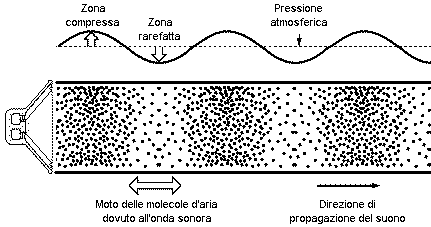

Come abbiamo già osservato nel paragrafo dedicato il suono è generato da piccole variazioni nella pressione atmosferica che si propagano nello spazio e nel tempo e fino alla fine degli anni '40 del secolo scorso poteva essere trasdotto solo dall'apparato uditivo umano oppure da apparati microfonici utilizzati per le trasmissioni radio dei segnali ma non poteva essere memorizzato su alcun tipo di supporto dedicato a una diffusione culturale di massa. In realtà esistevano già diverse tecnologie dedicate alla memorizzazione delle onde sonore ma o erano di scarsa qualità e diffusione come i fonografi e i grammofoni o erano utilizzate solo a livello sperimentale oppure erano dedicate alle comunicazioni tra apparati militari.

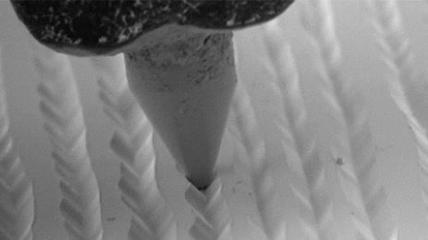

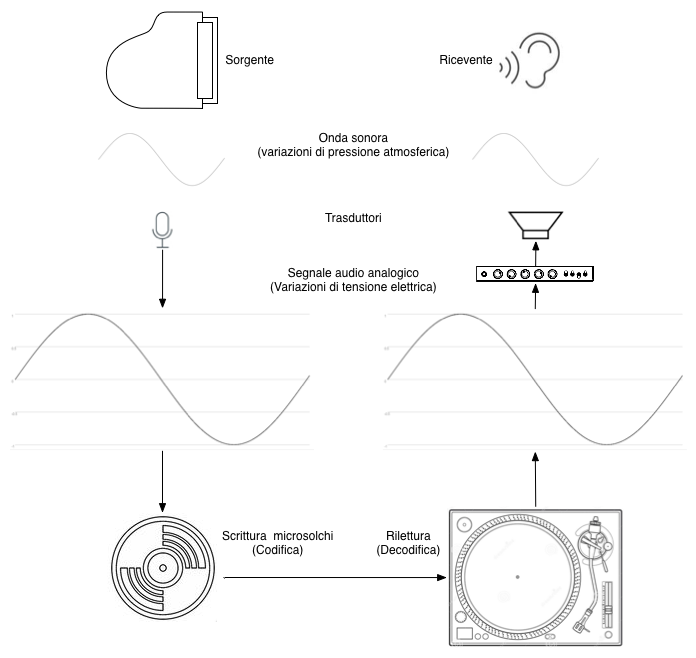

Il solo veicolo di trasmissione di eventi sonori a fini musicali restava la partitura che doveva essere interpretata da un esecutore umano e, se qualcuno voleva ascoltare un determinato brano doveva recarsi in un teatro o in una sala da concerti che lo aveva in cartellone. Sottolineiamo il fatto che l'esecuzione (così come l'ascolto) era unica e non ripetibile e la sola memoria in grado di conservare i suoni era quella umana. Tutto questo fino al 1948, anno in cui negli Stati Uniti la Columbia ha brevettato il primo disco in vinile a 33 giri nei formati da 25 e da 30 cm e dove la forma d'onda (così come avveniva in precedenza con i dischi a 78 giri) era stampata in microsolchi che si sviluppavano a spirale lungo la superfice del disco e che erano letti da una testina del giradichi.

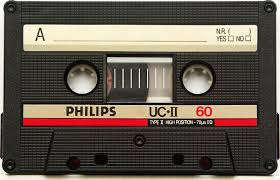

L'anno successivo (1949) viene inoltre introdotto sul mercato un altro tipo di supporto dedicato alla conservazione e riproduzione del suono: i primi registratori a nastro magnetico avvolto su bobine mentre successivamente nel 1964 la Philips commercializza in Europa la musicassetta a quattro tracce. E' cominciata l'era della fruizione musicale (e culturale) di massa che dopo centinaia di anni ha modificato profondamente e definitivamente il nostro rapporto con il mondo dei suoni.

Tutti i supporti e i sistemi di memorizzazione delle onde sonore appena esposti (oltre ad altri che non ho ritenuto opportuno citare in questa sede) appartengono al mondo dell'audio analogico in quanto l'informazione o meglio la rappresentazione dell'onda sonora avviene in modo continuo e analogo rispetto alle originali variazioni di pressione atmosferica. Questo perchè i dispositivi di registrazione analogici (trasduttori o microfoni) trasformano le variazioni di pressione atmosferica in variazioni di voltaggio di un segnale elettrico, che possono essere memorizzate su supporti meccanici (dischi in in vinile) o elettromagnetici (nastri magnetici) per poi essere eventualmente riprodotte una o più volte in momenti successivi. Questa oltre che essere stata una epocale rivoluzione tecnologica ha influito enormemente anche sulla diffusione musicale nella società, sui ruoli della musica all'interno della stessa e sullo sviluppo dei linguaggi strettamente legati alle arti sonore o musicali.

Nel 1971 comincia una nuova rivoluzione che però questa volta è strettamente tecnica (sotto un punto di vista culturale e sociale non fa

altro che amplificare e velocizzare il porcesso di diffusione globale delle informazioni già in atto): la nascita dell'audio digitale. In

quell'anno infatti i laboratori di ricerca della NHK (la radio televisione pubblica giapponese) realizzano il primo registratore audio digitale che,

attraverso la tecnica della PCM (Pulse Code Modulation)

brevettata dal britannico A.Reeves nel 1937 permette una codifica binaria del suono mentre nel 1976 Thomas Stockhham, docente del MIT, realizza la

prima registrazione audio digitale su nastro magnetico presso il Teatro dell'Opera di Santa Fe che porterà infine all'introduzione sul mercato nel

1982 da parte di Philips e Sony dei CD (Compact Disc) ottici con lettore al laser tuttora di uso comune (anche se è già in atto il loro declino

tecnologico verso altri tipi di condivisione musicale digitale). Ai nostri giorni ormai quasi tutte le informazioni legata all'audio (e non solo) sono digitali,

ma in cosa differisce l'audio digitale rispetto all'audio analogico? Fondamentalmente nel fatto che nel primo abbiamo una rappresentazione

continua di un segnale mentre nel secondo una rappresentazione discreta, ovvero si effettuano misurazioni del voltaggio che scorre

in un cavo proveniente da un microfono (rappresentazione continua) a istanti di tempo separati da un tempo delta costante come illustrato nel prossimo paragrafo.

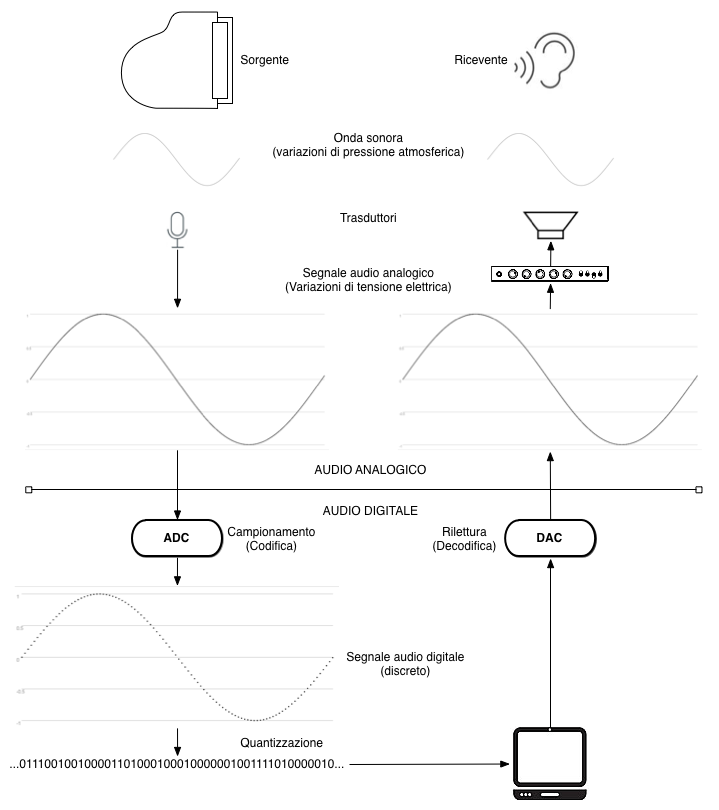

Catena elettroacustica digitale

Possiamo pensare l'audio digitale come un prolungamento della catena elettroacustica analogica che abbiamo già incontrato:

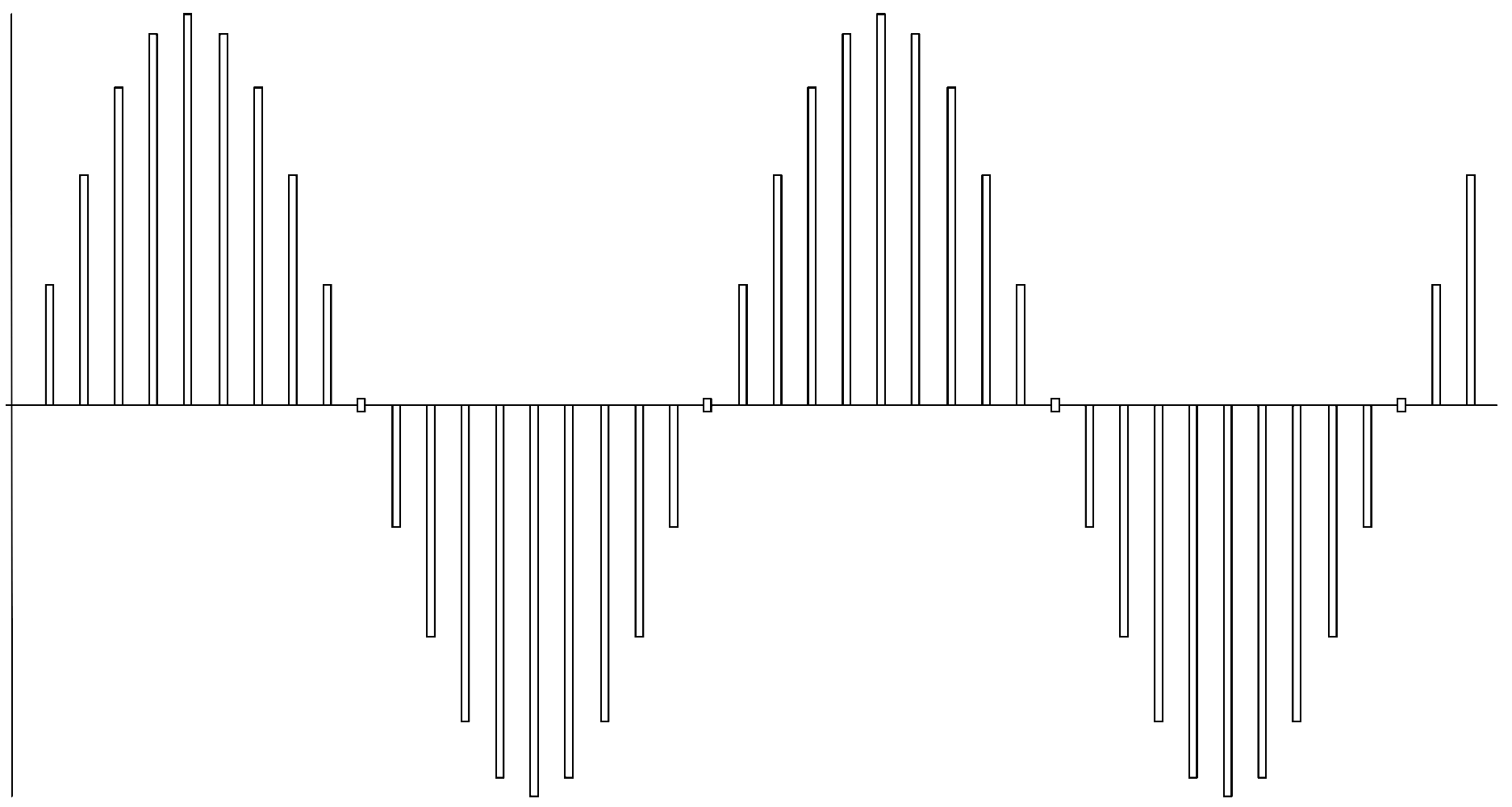

Il processo di campionamento consiste nel misurare a precisi istanti di tempo separati tra loro da un tempo delta costante chiamato periodo di campionamento l'ampiezza istantanea del segnale audio analogico espressa sotto forma di tensione elettrica. La singola misura è chiamata campione (sample) e dopo aver subito un processo di quantizzazione produce una sequenza di parole binarie che corrispondono all’andamento del segnale. Osserviamo nel dettaglio il processo appena illustrato analizzando i diversi tipi di segnale.

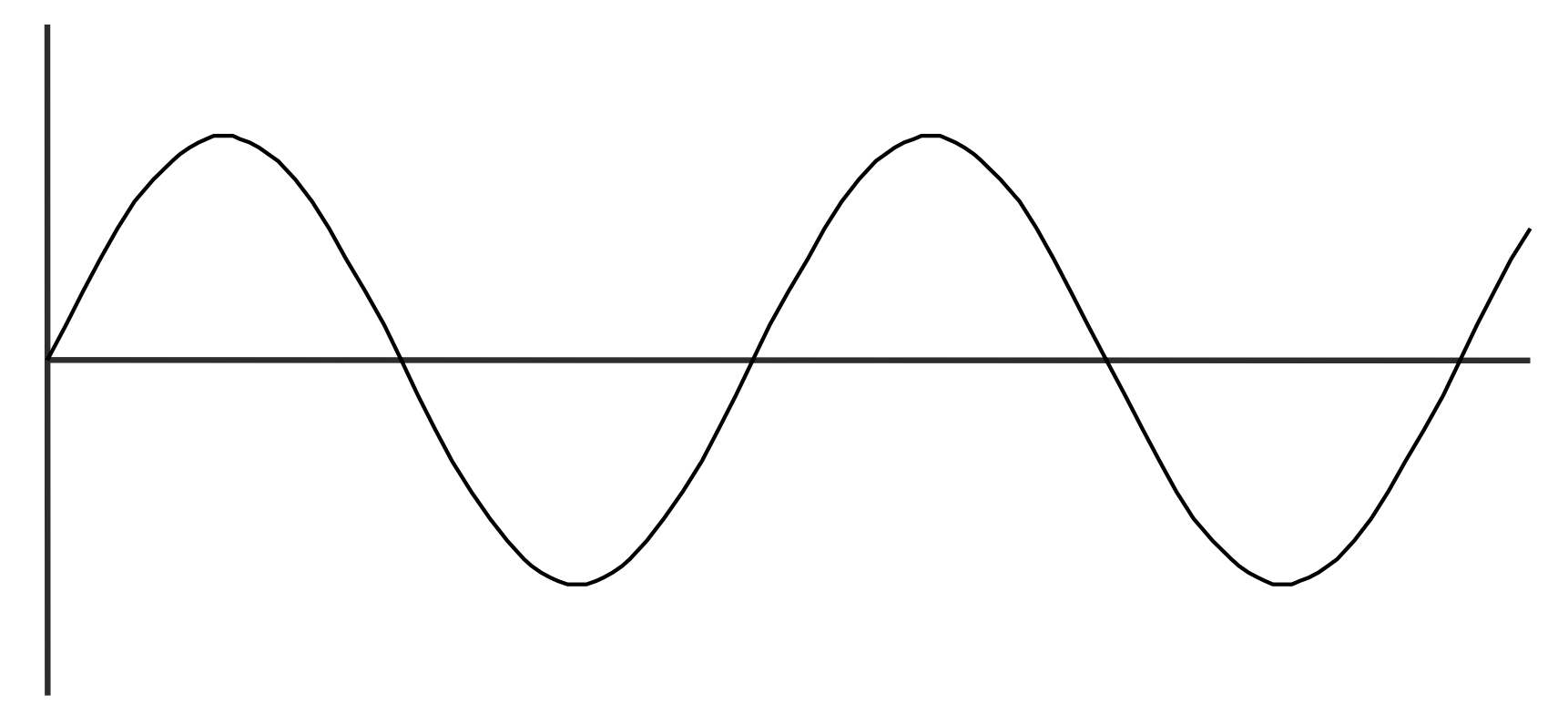

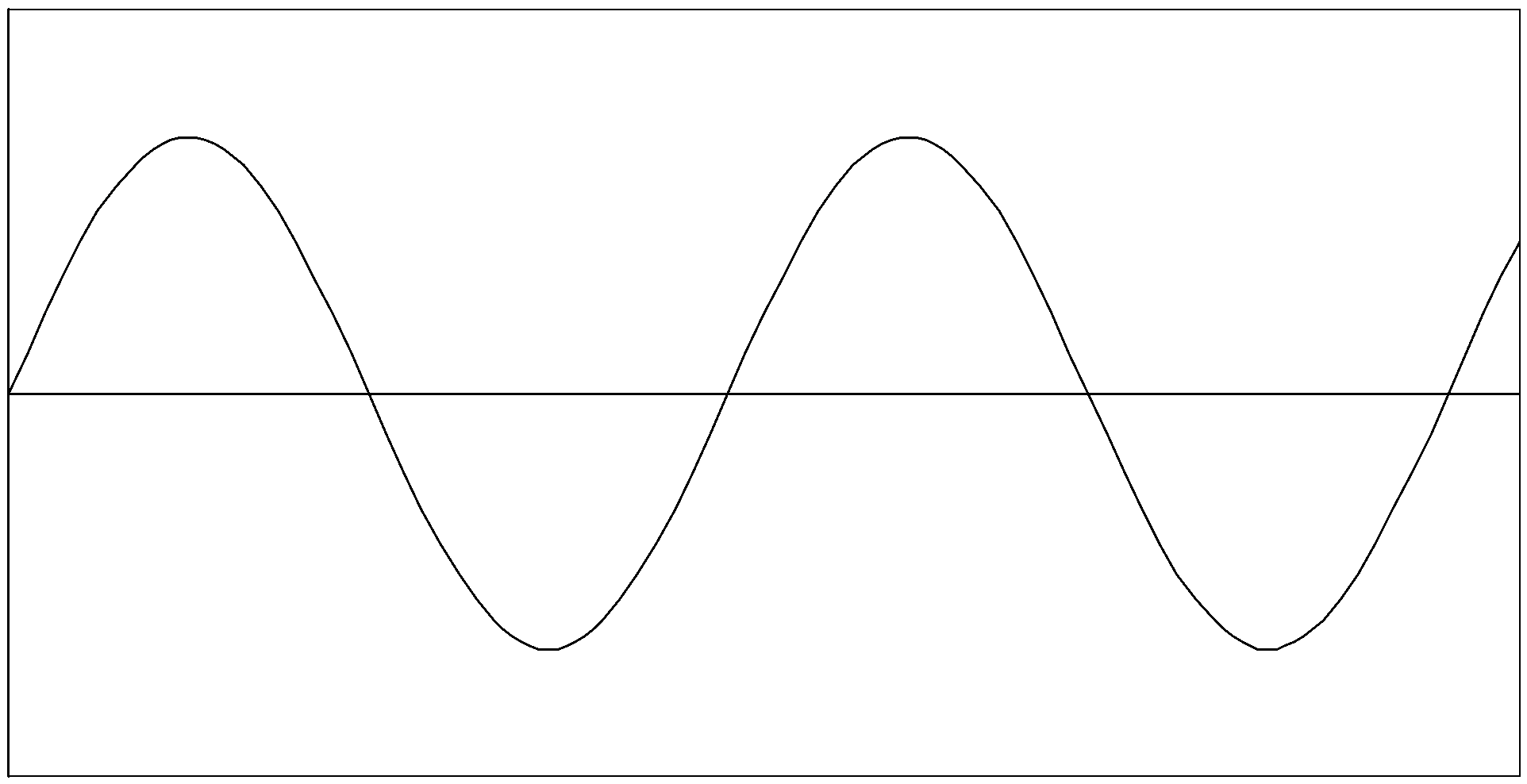

Segnale analogico

I microfoni trasducono l'energia meccanica propria delle onde sonore in energia elettrica utilizzando diverse tecnologie (induzione elettromagnetica, induzione elettrostatica o piezoelettricità). L'energia elettrica generata (corrente alternata) scorre nel cavo collegato al microfono e il suo andamento segue in modo analogo l'andamento delle variazioni di pressione originali trasportando l'informazione attraverso tutti i dispositivi connessi tra loro all'interno di una catena elettroacustica.

Questo tipo di segnale è continuo sia nel tempo che in ampiezza.

Segnale campionato

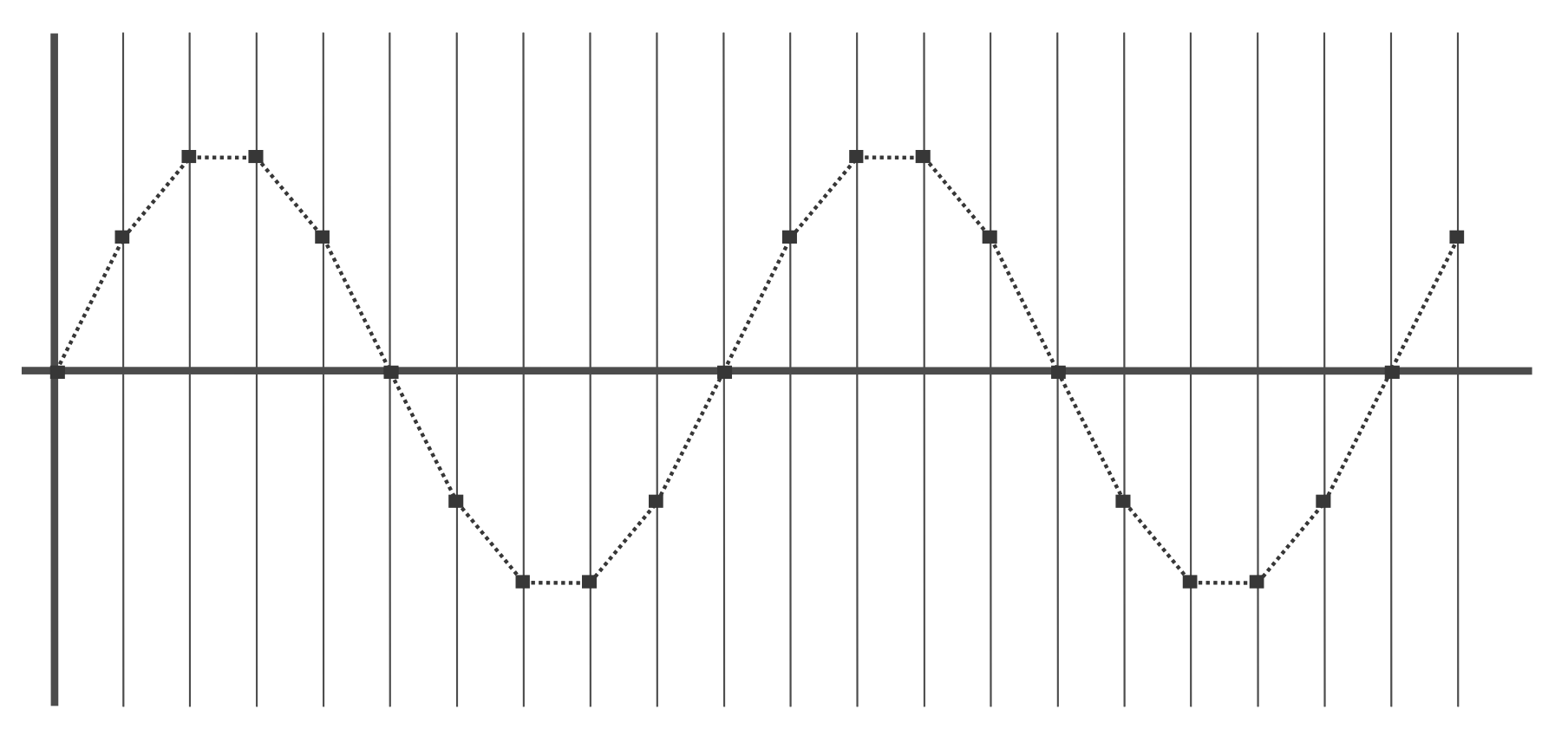

Abbiamo affermato che campionare un segnale significa misurarne l'ampiezza (y) a ogni periodo di campionamento ottenendo un segnale discreto nel tempo e continuo in ampiezza:

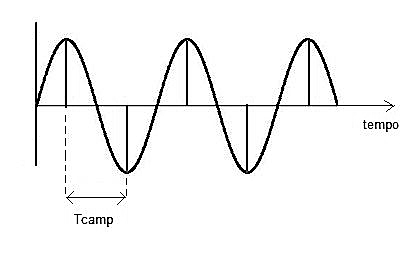

A questo punto però ci troviamo di fronte ad una questione: ogni quanto campionare il segnale? Teoricamente possiamo affermare che più è breve il periodo di campionamento minore sarà la perdita di informazioni tra un campione e il successivo ottenendo un segnale digitale più simile all’originale fino al limite ideale (periodo infinitamente piccolo) in cui il segnale analogico e quello campionato coincidono.

Praticamente però ci sono limiti tecnologici nella costruzione dei convertitori ADC che non ci permettono di arrivare a periodi così brevi. Dobbiamo allora partire dal presupposto che i campioni devono essere prelevati con velocità dipendente dalla variazione del segnale e tale velocità dipende dalla componente armonica con frequenza più alta che sarà quella che determina il periodo di campionamento.

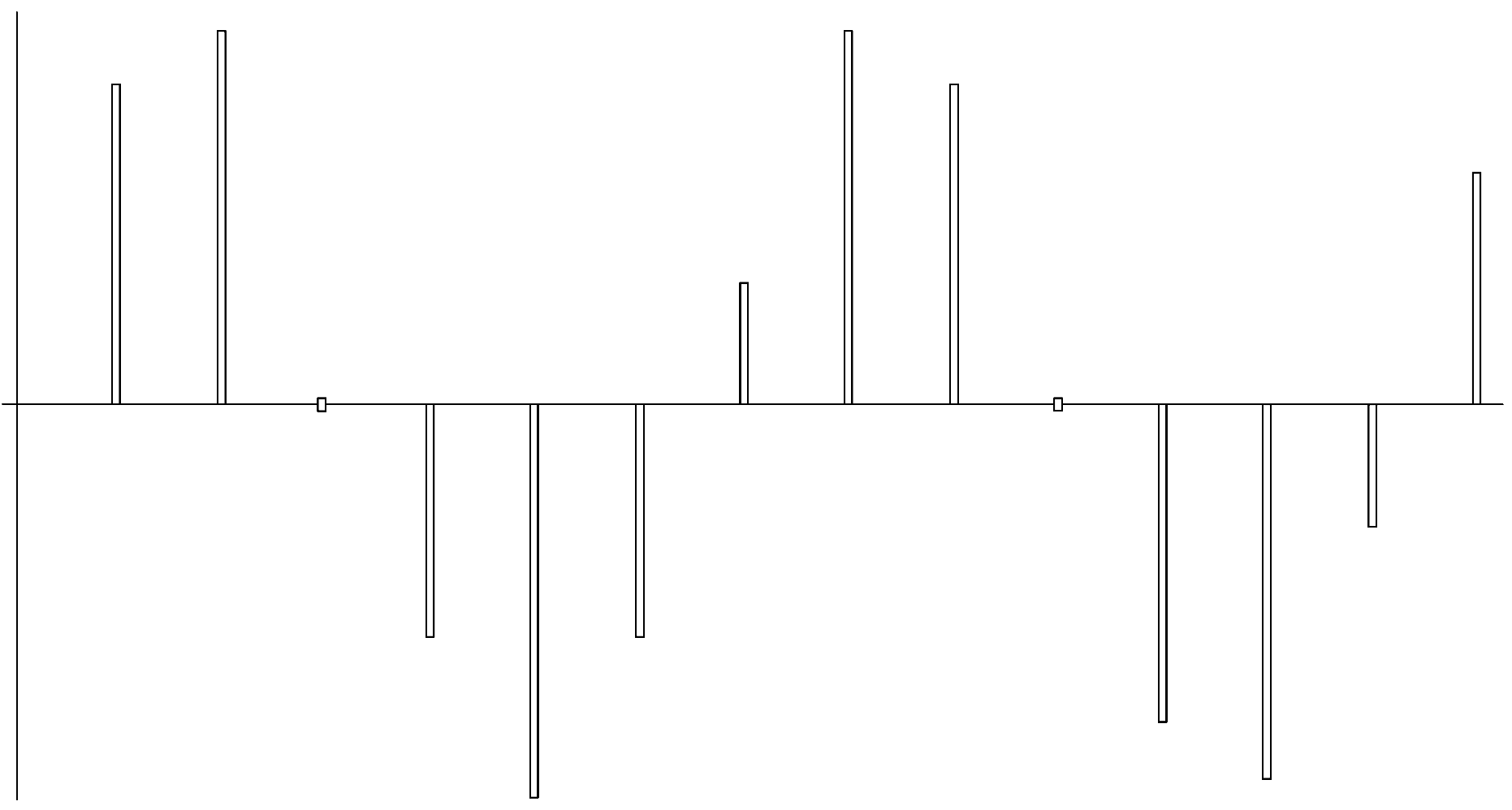

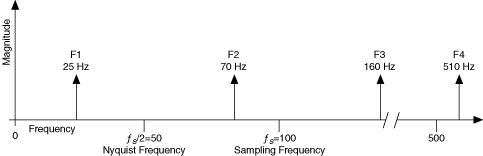

Le frequenze dei parziali di uno spettro sono espresse in Hertz ovvero in cicli per secondo (cps), uniformiamo allora l'unità di misura e sostituiamo il periodo di campionamento con la rata di campionamento (Sample rate o sr o Audio rate) che è espressa anch'essa in Hertz e ci dice quanti campioni sono misurati in un secondo. Quanto più alta sarà la frequenza di campionamento, tanto più accurata sarà la descrizione del segnale. Ma torniamo alla domanda iniziale: qual è il valore minimo della frequenza di campionamento? e ancora: basta farla coincidere con la frequenza del parziale più alto presente nello spettro del suono da campionare? No. Sono necessari almeno due campioni per periodo del segnale o meglio: la frequenza di campionamento deve essere almeno il doppio della frequenza massima presente nello spettro del segnale (frequenza di Nyquist).

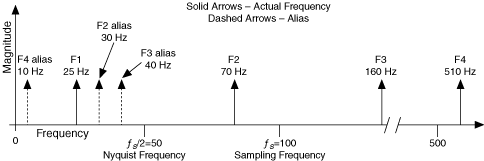

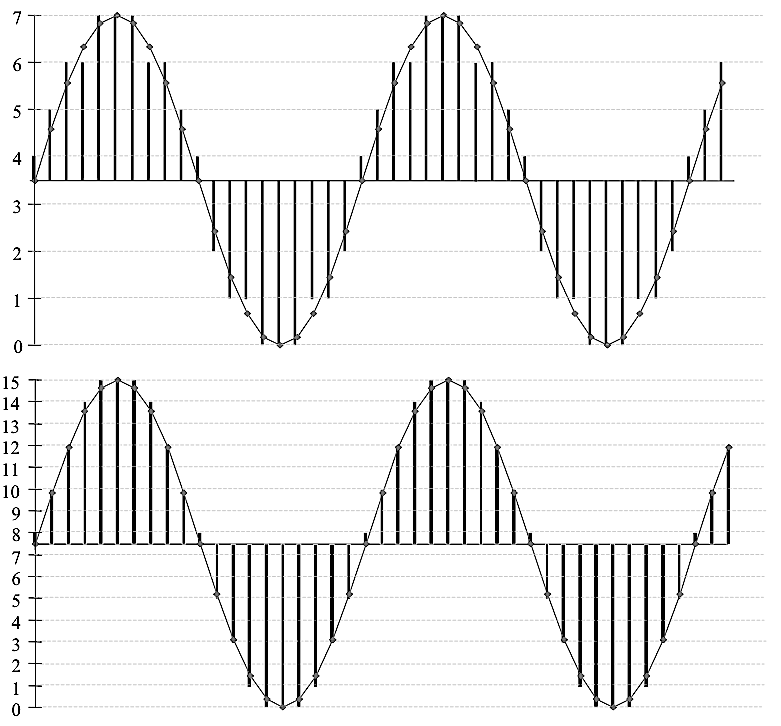

L'enunciato appena esposto è desunto dal Teorema di Nyquist-Shannon e se non adottato come regola oltre che ad una rappresentazione imprecisa del segnale porta alla generazione di errori nel segnale durante la rilettura dei campioni. Questo tipo di errori è dato dal fenomeno dell'aliasing o foldover. Ma in cosa consiste questo fenomeno? Come possimo osservare nelle figure seguenti se la frequenza di campionamento è troppo bassa le misure rilevate possono descrivere una frequenza più bassa di quella reale:

Sarà poi questa frequenza (chiamata frequenza alias) a essere riprodotta nel momento in cui andiamo a rileggere in modo sequenziale i campioni. Possiamo dunque affermare che tutte le frequenze al di sopra della frequenza di Nyquist (foldover) generano frequenze alias non presenti nel segnale originale e che sono al di sotto di tale soglia.

Questo fenomeno genera modifiche anche importanti a livello timbrico e le possibili soluzioni sono due:

Utilizzare la più alta frequenza di campionamento possibile innalzando di fatto la frequenza di Nyquist oltre la soglia dell'udibilità umana (20.000Hz)

Inserire un filtro passa-basso (anti aliasing) sia prima del campionamento che dopo la rilettura (per compensare eventuali modifiche delle fasi operate dal filtro in ingresso)

La rata di campionamento dello standard CD è stata fissata nel 1982 a 44.100 Hz proprio perchè è il doppio della soglia di udibilità umana (20.000*2) più 4.100 Hz che compensano la pendenza di taglio del filtro passa-basso in ingresso. Ai giorni nostri quasi tutti gli hardware dedicati all'audio digitale possono arrivare a frequenze di campionamento a 48.000 e 96.000 Hz annullando di fatto qualsiasi problematica relativa alla perdita di informazioni tra campioni successivi e al fenomeno dell'aliasing.

Segnale quantizzato

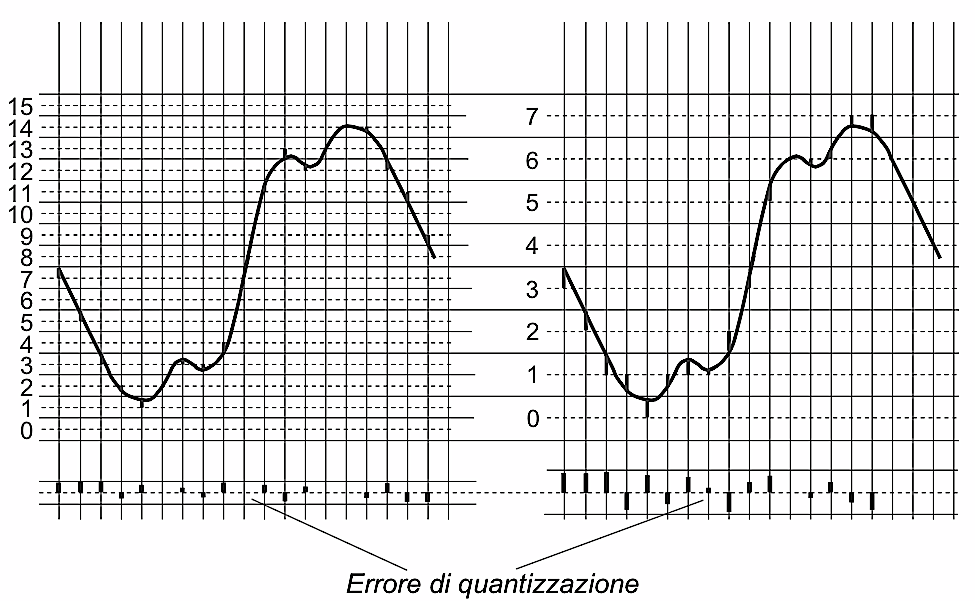

La trasformazione dell'ampiezza di un segnale da continua a discreta prende il nome di quantizzazione. Ogni valore misurato dal processo di campionamento (ampiezza istantanea) deve essere associato a un nuovo valore compreso in un insieme discreto di livelli introducendo in questo modo una serie di imprecisioni chiamata errori di quantizzazione, poiché valori differenti nel segnale analogico possono essere approssimati sullo stesso livello, divenendo indistinguibili.

L'ambito di ampiezza che vogliamo rappresentare (range) si chiama Valore di Fondo Scala (VFS) e se per definizione è compreso tra +/- 1 nel momento in cui andiamo a misurare le differenze di tensione elettrica del segnale analogico è espresso in Volt e può assumere valori differenti. Ad esempio se il segnale che vogliamo misurare è compreso tra 5 e 20 Volt:

VFS = 20 - 5 = 15

Questo parametro ci serve per misurare l'errore massimo di quantizzazione (Emax) attraverso la formula seguente:

Emax = VFS/2Q

Dove Q è uguale al numero di livelli di quantizzazione. Così come nell'audio analogico possiamo dire che il segnale rappresentato è uguale al segnale originale sommato al rumore (fruscio) e possiamo rappresentare questo rapporto con il SNR (Signal to Noise Ratio) anche nell'audio digitale possiamo stimare la distorsione indotta dal processo di quantizzazione attraverso il calcolo del SQNR medio (Signal Quantization Noise Ratio medio):

SQNR = Q*(√3/2)

In deciBel:

SQNRdB = 10log10SQNR^2

Risulta a questo punto evidente come utilizzando un numero maggiore di "scalini" (Q) la quantizzazione sia più precisa e la distorsione minore, infatti un SQNR alto è sempre indice di maggiore qualità. Notiamo che il calcolo appena illustrato vale per un SQNR medio e a parità di errore di quantizzazione le ampiezze più piccole in valore assoluto sono distorte maggiormente (in proporzione) rispetto a quelle più grandi. Per ovviare a questo problema e al fatto che l'essere umano percepisce meglio le variazioni che interessano ampiezze basse sono state pensate due differenti tecniche di quantizzazione:

Uniforme o lineare dove il numero di livelli di quantizzazione è uguale dagli intervalli di ampiezza del segnale originale (intervalli equi-spaziati).

E' la tecnica standard utilizzata dai costruttori dei convertitori A/D e D/A.

Non uniforme o non lineare dove il numero di livelli di quantizzazione è diverso dagli intervalli di ampiezza del segnale originale ovvero c'è più precisione nel quantizzare certi intervalli e meno per altri (intervalli spaziati differentemente): le ampiezze deboli sono spaziate meno di quelle elevate slegando in questo modo l'SQNR dalla gamma dinamica.

Generalmente vengono assegnati i valori a regioni uniformi sulla scala logaritmica ottenendo in questo modo una maggiore qualità: con 8 "scalini" logaritmici possiamo ottenere la gamma dinamica di un quantizzatore lineare a 13/14 "scalini" ottenendo inoltre un risparmio di memoria sul supporto. I contro sono che un convertitore a 8 "scalini" logaritmico funziona meglio di un equivalente lineare alle ampiezze basse, ma peggio alle ampiezze elevate e risulta più complesso applcare le tecniche di elaborazione del segnale in quanto la somma di due segnali corrisponde al prodotto.

Segnale numerico

L'ampiezza di un segnale analogico espressa in Volt può essere rappresentata da un numero in un sistema decimale mentre l'ampiezza di un segnale digitale deve essere espressa attraverso un sistema binario in quanto tutti i sistemi digitali accettano solo due stati:

- 0 = circuito aperto = falso

- 1 = circuito chiuso = vero

Nel sistema binario i numeri sono espressi in parole di diversa lunghezza e ogni singolo elemento è chiamato cifra significativa o in termini informatici bit che significa binary digit. Il bit infatti è la più piccola unità d'informazione manipolabile da un calcolatore digitale ed è possibile rappresentare fisicamente questa informazione con un segnale elettrico o magnetico che se supera una determinata soglia corrisponde al valore 1. Appare ora evidente come gli"scalini" di cui parlavamo pocanzi corrispondano al numero di bit o soglie con i quali andiamo a rappresentare un valore di ampiezza. Con un bit possiamo dunque ottenere due soli valori: 0 e 1 mentre con due bit quattro valori diversi (22):

| 0 | 0 |

| 0 | 1 |

| 1 | 0 |

| 1 | 1 |

Con tre bit (23):

| Valore binario | Valore decimale |

|---|---|

| 000 | 0 |

| 001 | 1 |

| 010 | 2 |

| 011 | 3 |

| 100 | 4 |

| 101 | 5 |

| 110 | 6 |

| 111 | 7 |

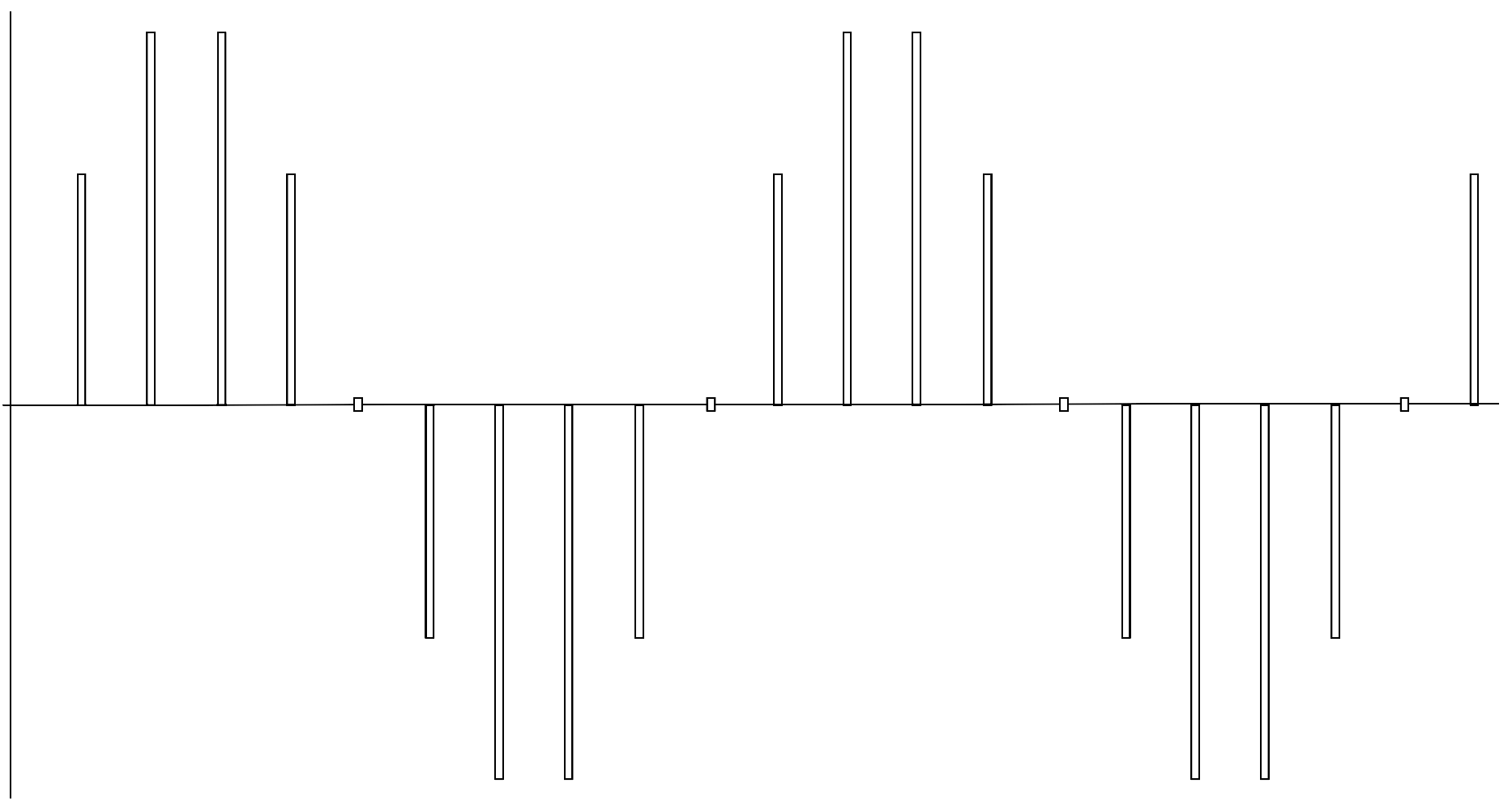

E via dicendo, per un gruppo di n bit possiamo rappresentare 2n valori. Nell'immagine seguente possiamo visualizzare la differenza che intercorre tra una quantizzazione lineare a 3 bit (8 livelli) e una a 4 bit (16 livelli):

Infine facciamo un esempio della quantizzazione di un segnale analogico compreso tra +/- 5V con una profondità di 8 bit:

| Valore di tensione | Valore binario |

|---|---|

| [-5.000, -4.961] | 00000000 |

| [-4.961, -4.922] | 00000001 |

| [-4.922, -4.883] | 00000010 |

| [-4.883, -4.844] | 00000011 |

| ... | 00000100 |

| ... | ... |

| ... | ... |

| ... | 11111011 |

| [+4,844, +4,883] | 11111100 |

| [+4,883, +4,922] | 11111101 |

| [+4,922, +4,961] | 11111110 |

| [+4,961, +5,000] | 11111111 |

In questo caso abbiamo una precisione del segnale che è data da: 10/28 Volt = 10/256 Volt = 0,039 Volt e tutti i valori di tensione compresi in un intervallo di 0,039V saranno rappresentati dallo stesso valore.

In informatica ci sono unità di informazioni che sono caratterizzate dal numero di bit che le descrivono ad esempio il byte è composto da 8 bit e permette ad esempio di stoccare un carattere (char) o una cifra (int) compresa tra 0 (00000000) e 255 (11111111). Questo raggruppamento di numeri permette una migliore leggibilità come quando in base decimale raggruppiamo un numero a tre per poter distinguere le migliaia (il numero 1.256.245 è decisamente più leggibile che 1256245). Un'altra unità di informazione composta da 16 bit è chiamata parola (word) mentre un'informazione a 32 bit parola doppia (double word).

Dal Dicembre 1998 l'organismo internazionale IEC (International Electrotechnical Commission) ha standardizzato alcune unità di misura informatiche:

- Kilobite (KB) = 1000 byte (prima del 1998 era 210 = 1024 byte).

- Megabite (MB) = 1000 KB = 1.000.000 byte (prima del 1998 era 220 = 1024 KB = 1.048.576 byte).

- Gigabite (GB) = 1000 MB = 1.000.000.000 byte (prima del 1998 era 230 = 1024 MB = 1.073.741.824 byte).

- Terabite (TB) = 1000 GB = 1.000.000.000.000 byte (prima del 1998 era 240 = 1024 GB = 1.099.511.627.776 byte).

Conoscendo la frequenza di campionamento in Hertz (Fc), la profondità di quantizzazione in bit (N) e la durata del flusso audio in secondi (D) possiamo stabilire quanti bit abbiamo bisogno per memorizzare un segnale digitale monofonico non compresso:

Size = Fc * N * D

Il numero di bit compreso nell'unità di tempo (un secondo) si chiama bit rate e si misura in bps (bit per secondo).

bitrate = Fc * N

Qua sotto alcuni valori standard:

| Supporto | Fc (Hz) | Bit | SQNR (dB) | Canali | Bit rate (KBps) |

|---|---|---|---|---|---|

| Telefono | 8.000 | 8 | 48 | 1 | 8.00 |

| Radio AM | 11.025 | 8 | 48 | 1 | 11.05 |

| Radio FM | 22.050 | 16 | 96 | 2 | 88.20 |

| CD Audio | 44.100 | 16 | 96 | 2 | 176.40 |

| DAT | 48.000 | 16 | 96 | 2 | 192.00 |

| DVD Audio | 192.000 | 24 | 144 | 6 | 1200.00 |